-

關於我們+

-

產品與服務+

-

解決方案+

-

客戶案例+

-

AI創新中心+

-

投資者關係+

-

聯繫我們+

-

申請試用+

申請試用-

關於我們+

產品與服務+

解決方案+

客戶案例+

AI創新中心+

投資者關係+

聯繫我們+

申請試用+

申請試用-

What

不僅要做出模型預測,還要給出模型產生預測結果的理由。知其然更要知其所以然

可解釋機器學習(Intepretable Machine Learning,縮寫為IML)的核心思想在於選擇模型時,預測精度和可解釋性並重,並儘量找到二者之間的最佳平衡

Backdrop

銀行業的分析模型越來越多,所用的算法也複雜多樣

為了追求更高的模型精度,各種集成模型(如隨機森林、XGBoost)和深層網絡模型(如CNN、RNN、LSTM)成為熱點算法,但由於模型過於復雜,這些算法已經成為無法理解的黑箱,業務上難以應用。

Innovation

兼顧模型的準確性和可解釋性

內在可解釋(Intrinsic Interpretability)通過改良模型結構,增強模型靈活表徵能力,提升模型的預測精度,如GAMxNN、RuleFit、Falling Rule List

事後可解釋(Post-hoc Interpretability):保持複雜模型精度不變,通過事後的歸因解析及可視化來獲得模型的部分可解釋性,如:LIME、SHAP

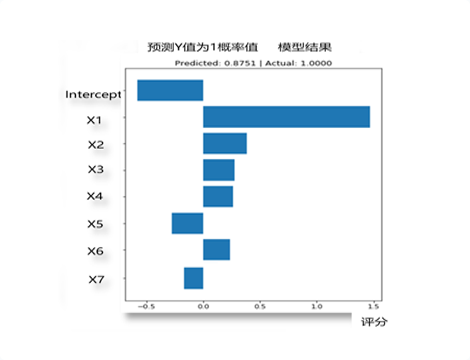

Value

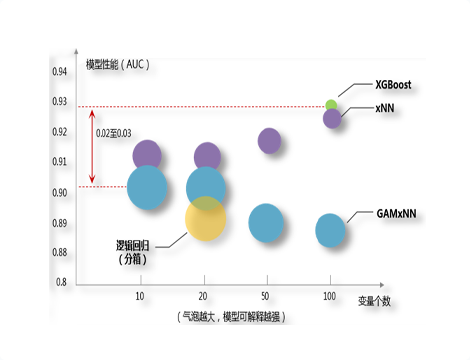

在某銀行的基金推薦點擊預測項目中與XGBoost算法精度相當,特徵變量從100個大幅縮減為10個,同時能夠可視化展示這些特徵帶來的量化影響顯著提高了業務上的可用性

總體可解釋性有助於業務人員理解模型的重要特徵個體可解釋性便於客戶畫像,進行個性化精準營銷

可翻譯分析模型

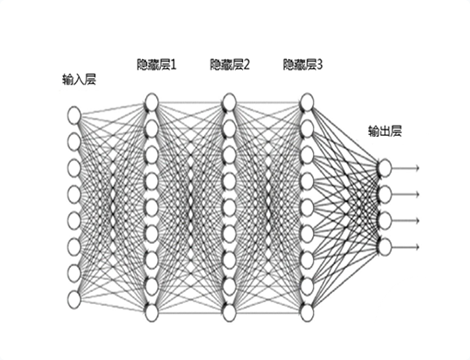

複雜的深層神經網路黑箱

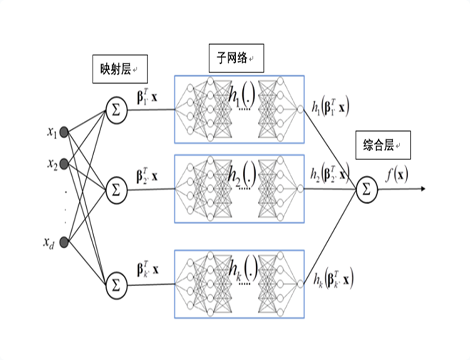

xNN

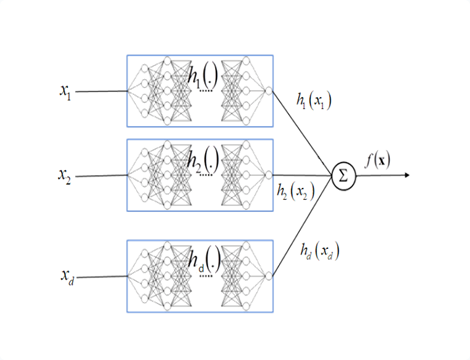

GAMxNN

多種算灋的實際應用

模型效能與特徵數量對比

總體可解釋性

個體可解釋性